Partitionner son serveur dédié OVH pour une utilisation avec Proxmox V6

Template « Proxmox VE 6 (64bits) »

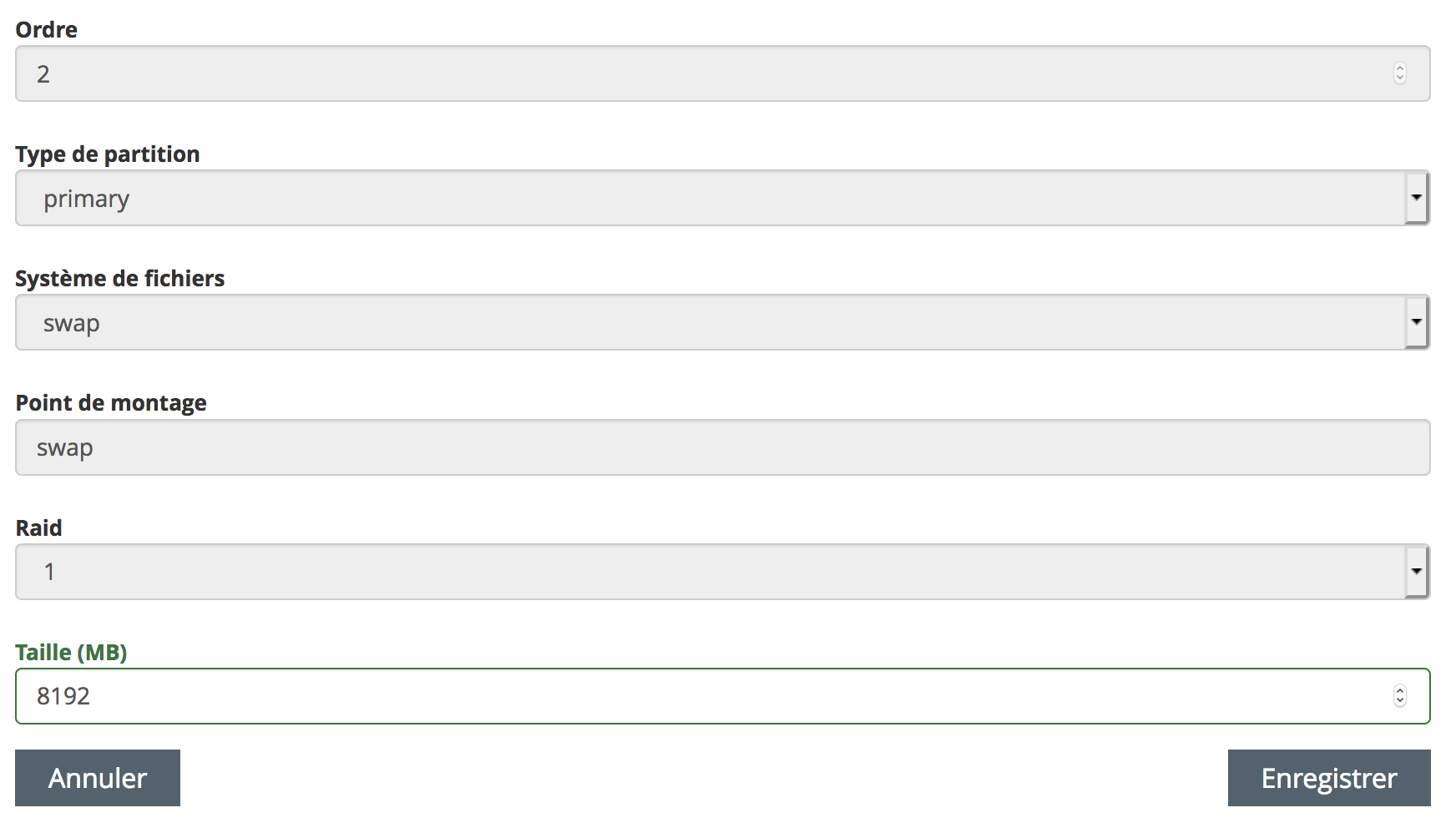

Schéma de partition

Je prend ici l’exemple d’un serveur avec 32GB de RAM et 4 disques dur de 2To HDD SATA Soft RAID :

- J’ai fait le choix d’organiser le SWAP à 1/4 de la mémoire RAM, soit 8 Go (8 192 MB). Ce serveur ayant 4 disques dur en raid logiciel, j’obtiens alors un taille total du swap de 32 Go (ce qui correspondla taille de ma mémoire RAM).

- Pour la partition réservée au système « / », j’ai doublé la valeur par défaut proposé dans le « template » OVH ce qui finalement donne 40Go (40 960 MB), ainsi je suis large sur les évolutions à venir de Proxmox, l’installation d’applications tierces sur le host principal, ou le stockage de certains logs de sécurité qui pourraient être volumineux, …)

- Le reste du disque dur sera utilisé pour les données du serveur Proxmox, qui sera ensuite réparti en raidZ zfs sur les 4 disques de 2To (J’obtiendrais ainsi un espace de stockage d’environs 70% de la taille total restantes des 4 disques soit près de 5 To sur les 7 To) .

lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT sda 8:0 0 1.8T 0 disk ├─sda1 8:1 0 511M 0 part ├─sda2 8:2 0 20G 0 part │ └─md2 9:2 0 20G 0 raid1 / ├─sda3 8:3 0 1G 0 part [SWAP] ├─sda4 8:4 0 1.8T 0 part │ └─md4 9:4 0 1.8T 0 raid1 │ └─vg-data 253:0 0 1.8T 0 lvm /var/lib/vz └─sda5 8:5 0 2M 0 part sdb 8:16 0 1.8T 0 disk ├─sdb1 8:17 0 511M 0 part ├─sdb2 8:18 0 20G 0 part │ └─md2 9:2 0 20G 0 raid1 / ├─sdb3 8:19 0 1G 0 part [SWAP] └─sdb4 8:20 0 1.8T 0 part └─md4 9:4 0 1.8T 0 raid1 └─vg-data 253:0 0 1.8T 0 lvm /var/lib/vz sdc 8:32 0 1.8T 0 disk ├─sdc1 8:33 0 511M 0 part /boot/efi ├─sdc2 8:34 0 20G 0 part │ └─md2 9:2 0 20G 0 raid1 / ├─sdc3 8:35 0 1G 0 part [SWAP] └─sdc4 8:36 0 1.8T 0 part └─md4 9:4 0 1.8T 0 raid1 └─vg-data 253:0 0 1.8T 0 lvm /var/lib/vz sdd 8:48 0 1.8T 0 disk ├─sdd1 8:49 0 511M 0 part ├─sdd2 8:50 0 20G 0 part │ └─md2 9:2 0 20G 0 raid1 / ├─sdd3 8:51 0 1G 0 part [SWAP] └─sdd4 8:52 0 1.8T 0 part └─md4 9:4 0 1.8T 0 raid1 └─vg-data 253:0 0 1.8T 0 lvm /var/lib/vz

fdisk -l

Disk model: HGST HUS726020AL

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: 7AEDB46F-6D55-4F12-9EFA-820E06AF6F0B

Device Start End Sectors Size Type

/dev/sda1 34 1046527 1046494 511M EFI System

/dev/sda2 1046528 84932607 83886080 40G Linux RAID

/dev/sda3 84932608 101709823 16777216 8G Linux filesystem

/dev/sda4 101709824 3907025071 3805315248 1,8T Linux RAID

/dev/sda5 3907025072 3907029134 4063 2M Linux filesystem

Disk /dev/sdb: 1,8 TiB, 2000398934016 bytes, 3907029168 sectors

Disk model: HGST HUS726020AL

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: 231C39B5-40C6-49DB-A41F-B018DBD4BA93

Device Start End Sectors Size Type

/dev/sdb1 34 1046527 1046494 511M EFI System

/dev/sdb2 1046528 84932607 83886080 40G Linux RAID

/dev/sdb3 84932608 101709823 16777216 8G Linux filesystem

/dev/sdb4 101709824 3907025071 3805315248 1,8T Linux RAID

Disk /dev/sdd: 1,8 TiB, 2000398934016 bytes, 3907029168 sectors

Disk model: HGST HUS726020AL

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: FD99AD38-105C-452E-9E18-E74643F1FAA5

Device Start End Sectors Size Type

/dev/sdd1 34 1046527 1046494 511M EFI System

/dev/sdd2 1046528 84932607 83886080 40G Linux RAID

/dev/sdd3 84932608 101709823 16777216 8G Linux filesystem

/dev/sdd4 101709824 3907025071 3805315248 1,8T Linux RAID

Disk /dev/sdc: 1,8 TiB, 2000398934016 bytes, 3907029168 sectors

Disk model: HGST HUS726020AL

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: C6EA383B-0112-4E78-AF63-5E1FB94B815F

Device Start End Sectors Size Type

/dev/sdc1 34 1046527 1046494 511M EFI System

/dev/sdc2 1046528 84932607 83886080 40G Linux RAID

/dev/sdc3 84932608 101709823 16777216 8G Linux filesystem

/dev/sdc4 101709824 3907025071 3805315248 1,8T Linux RAID

Disk /dev/md2: 40 GiB, 42916118528 bytes, 83820544 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/md4: 1,8 TiB, 1948187164672 bytes, 3805053056 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disk /dev/mapper/vg-data: 1,8 TiB, 1948182904832 bytes, 3805044736 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

swapon --show

/dev/sdd3 partition 8G 0B -2

/dev/sdc3 partition 8G 0B -3

/dev/sdb3 partition 8G 0B -4

/dev/sda3 partition 8G 0B -5

free -h

Mem: 31Gi 965Mi 29Gi 33Mi 835Mi 29Gi

Swap: 31Gi 0B 31Gi

Volumes RAID : md*

Les volumes RAID ont des noms de type /dev/md*

Voici quelques commandes utilent pour la gestion des partitions RAID :

# Lister les volumes RAID :

cat /proc/mdstat

# voir les details :

mdadm –query –detail /dev/md0

#definition du RAID dans /etc/mdadm/mdadm.conf

#mise à jour par la commande :

update-initramfs -u

#Formatage

mkfs -t ext4 /dev/md0

#Monter le volume RAID

mount -t ext4 /dev/md0 /var/data1

#Cas d’un disque raid defaillant :

mdadm –manage /dev/md0 –fail /dev/sdb

mdadm –query –detail /dev/md

mdadm –manage /dev/md0 –remove /dev/sdb

mdadm –manage /dev/md0 –add /dev/sdb

Désactiver le raid sur une partition :

mdadm –manage /dev/md4 –stop

mdadm –stop /dev/md4

Enlever sdc du raid1 :

mdadm –manage /dev/md2 –fail /dev/sdc2

mdadm –manage /dev/md2 –remove /dev/sdc2

Reconstruire la matrice RAID

mdadm –add /dev/md2 /dev/sdc2

cat /proc/mdstat

gdisk /dev/sda

GPT fdisk (gdisk) version 1.0.3

Partition table scan:

MBR: protective

BSD: not present

APM: not present

GPT: present

Found valid GPT with protective MBR; using GPT.

=> p #print

Disk /dev/sda: 3907029168 sectors, 1.8 TiB

Model: HGST HUS726020AL

Sector size (logical/physical): 512/512 bytes

Disk identifier (GUID): 7AEDB46F-6D55-4F12-9EFA-820E06AF6F0B

Partition table holds up to 128 entries

Main partition table begins at sector 2 and ends at sector 33

First usable sector is 34, last usable sector is 3907029134

Partitions will be aligned on 8-sector boundaries

Total free space is 0 sectors (0 bytes)

Number Start (sector) End (sector) Size Code Name

1 34 1046527 511.0 MiB EF00 primary

2 1046528 84932607 40.0 GiB FD00 primary

3 84932608 101709823 8.0 GiB 8300 primary

4 101709824 3907025071 1.8 TiB FD00 logical

5 3907025072 3907029134 2.0 MiB 8300 logical

=> d => 4

# ajouter partition

=> n => last sector : +100M

=> c => 4 => ceph data

# ajouter partition

=> n

=> c => 7 => ceph block

Système de fichier ZFS

Ce système de fichier offre aussi des fonctions de « snapshot » très utiles pour des solutions de sauvegarde à chaud ou de réplications.

Par exemple, dans le cadre d’un cluster avec Proxmox on pourra directement profiter de la réplication de « Container » entre les noeuds du cluster, et ainsi basculer en quelques secondes un service d’un serveur à l’autre.

Migrer vers une partition ZFS en RAIDZ (ie RAID5)

Voici la procédure que j’ai executé sur une serveur hébergé chez OVH pour mettre en place une partition en ZFS raidZ pour une utilisation avec Proxmox V6.

A gauche vous trouverez les commandes à executer pour effectuer la transition, à droit je rappel les commandes pour voir à chaque étape le statut des disques ou des actions réalisées.

Stopper les services proxmox

Démonter le volume à remplacer

Supprimr la partition logique (LVG)

Do you really want to remove and DISCARD active logical volume vg/data? [y/n]: y

Logical volume « data » successfully removed

Désactiver la partition RAID logiciel

mdadm –stop /dev/md4

mdadm –remove /dev/md4

mdadm –zero-superblock /dev/sd[abcd]4

#vérifier la conf

vi /etc/mdadm/mdadm.conf

# enlever le point de montage automatique

vi /etc/fstab

Créer le pool ZFS sur les disques physiques

zpool create -f -o ashift=12 zfspool raidz /dev/sda4 /dev/sdb4 /dev/sdc4 /dev/sdd4

zpool create -o ashift=12 rpool mirror /dev/sda5 /dev/sdb5

zfs set compression=lz4 rpool

zfs set atime=off rpool

systemctl enable zfs-import@rpool.service

zpool list

NAME SIZE ALLOC FREE CKPOINT EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT

zfspool 7.08T 768K 7.08T – – 0% 0% 1.00x ONLINE –

## Cas d’un RAIDZ avec disque en spare (en secours automatique) :

zpool create -f -o ashift=12 zfspool raidz /dev/sda4 /dev/sdb4 /dev/sdc4 spare /dev/sdd4

zfs list

NAME USED AVAIL REFER MOUNTPOINT

zfspool 543K 3.43T 128K /zfspool

Re-créer le point de montage /var/lib/vz (Proxmox)

# Organiser votre pool avec un sous volume ZFS

zfs create zfspool/vz

#re-définir le point de montage local par défaut pour Proxmox :

zfs set mountpoint=/var/lib/vz zfspool/vz

#monter automatiquement les volumes ZFS :

zfs mount -a;

Re démarer les services proxmox

lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sda 8:0 0 1.8T 0 disk

├─sda1 8:1 0 511M 0 part

├─sda2 8:2 0 20G 0 part

│ └─md2 9:2 0 20G 0 raid1 /

├─sda3 8:3 0 1G 0 part [SWAP]

├─sda4 8:4 0 1.8T 0 part

│ └─md4 9:4 0 1.8T 0 raid1

│ └─vg-data 253:0 0 1.8T 0 lvm /var/lib/vz

└─sda5 8:5 0 2M 0 part

lvdisplay ; vgdisplay

— Logical volume —

LV Path /dev/vg/data

LV Name data

VG Name vg

LV UUID lfUOGf-3zQr-Sy0L-IEXM-FdGz-WpUK-2cQYuJ

LV Write Access read/write

LV Creation host, time rescue.ovh.net, 2021-04-03 11:47:35 +0000

LV Status available

# open 0

LV Size 1,77 TiB

Current LE 464483

Segments 1

Allocation inherit

Read ahead sectors auto

– currently set to 256

Block device 253:0

vgdisplay

— Volume group —

VG Name vg

System ID

Format lvm2

Metadata Areas 1

Metadata Sequence No 3

VG Access read/write

VG Status resizable

MAX LV 0

Cur LV 1

Open LV 0

Max PV 0

Cur PV 1

Act PV 1

VG Size 1,77 TiB

PE Size 4,00 MiB

Total PE 464483

Alloc PE / Size 464483 / 1,77 TiB

Free PE / Size 0 / 0

VG UUID EjxWUq-PJ2L-YdWe-LuIW-B0gX-ct6e-4Yvwv1

cat /proc/mdstat ; mdadm --detail

cat /proc/mdstat

Personalities : [raid1] [linear] [multipath] [raid0] [raid6] [raid5] [raid4] [raid10]

md4 : active raid1 sdc4[0] sdd4[1] sdb4[3] sda4[2]

1902526528 blocks super 1.2 [4/4] [UUUU]

bitmap: 0/15 pages [0KB], 65536KB chunk

md2 : active raid1 sdc2[2] sdd2[3] sdb2[1] sda2[0]

41910272 blocks super 1.2 [4/4] [UUUU]

mdadm –detail /dev/md4

/dev/md4:

Version : 1.2

Creation Time : Sat Apr 3 11:47:32 2021

Raid Level : raid1

Array Size : 1902526528 (1814.39 GiB 1948.19 GB)

Used Dev Size : 1902526528 (1814.39 GiB 1948.19 GB)

Raid Devices : 4

Total Devices : 4

Persistence : Superblock is persistent

Intent Bitmap : Internal

Update Time : Sat Apr 3 21:01:32 2021

State : clean

Active Devices : 4

Working Devices : 4

Failed Devices : 0

Spare Devices : 0

Consistency Policy : bitmap

Name : md4

UUID : 8eb19bad:1a666c9e:5d519f81:4e129841

Events : 2

Number Major Minor RaidDevice State

0 8 36 0 active sync /dev/sdc4

1 8 52 1 active sync /dev/sdd4

2 8 4 2 active sync /dev/sda4

3 8 20 3 active sync /dev/sdb4

vi /etc/fstab

UUID=76256f3c-4bb1-4f09-94c9-aa09f49e7736 / ext4 defaults 0 1

LABEL=EFI_SYSPART /boot/efi vfat defaults 0 1

UUID=be6f874b-6de7-412b-bbe0-ce2454687400 /var/lib/vz ext4 defaults 0 0

UUID=f55df825-f713-4fc0-aee7-0033cf41bbec swap swap defaults 0 0

UUID=e71134ab-58c7-4c1e-9abf-f3d85bf8a219 swap swap defaults 0 0

UUID=6bfc5a1f-d712-4f9f-a0ab-eb02e5e5136b swap swap defaults 0 0

UUID=69fd3a33-71c7-4355-8fc9-d3e29bfbb74d swap swap defaults 0 0

sfdisk -s

/dev/sdc: 1953514584

/dev/sdb: 1953514584

/dev/sdd: 1953514584

/dev/md2: 41910272

/dev/md4: 1902526528

/dev/mapper/vg-data: 1902522368

total: 11661017504 blocks

zpool status, zpool list, zfs list

zpool list

NAME SIZE ALLOC FREE CKPOINT EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT

zfspool 7.08T 960K 7.08T – – 0% 0% 1.00x ONLINE –

zfs list

NAME USED AVAIL REFER MOUNTPOINT

zfspool 698K 4.98T 140K /var/lib/vz

zpool status

pool: zfspool

state: ONLINE

config:

NAME STATE READ WRITE CKSUM

zfspool ONLINE 0 0 0

raidz1-0 ONLINE 0 0 0

sda4 ONLINE 0 0 0

sdb4 ONLINE 0 0 0

sdc4 ONLINE 0 0 0

sdd4 ONLINE 0 0 0

errors: No known data errorszfs list

zfs list

NAME USED AVAIL REFER MOUNTPOINT

zfspool 907K 4.98T 140K /zfspool

zfspool/vz 140K 4.98T 140K /zfspool/vz

zfs list

NAME USED AVAIL REFER MOUNTPOINT

zfspool 1.07M 4.98T 140K /zfspool

zfspool/vz 140K 4.98T 140K /var/lib/vz

Mode rescue

En cas de problème de configuration (réseau, pare-feu, applicatif, …) les hébergeurs comme OVH ont une solution de pouvoir accéder au serveur en mode « rescue », c’est à dire que le boot ce fait sur un volume linux avec une configuration système par défaut simplifiée.

Accéder à la partition système de notre serveur

Connectez-vous en SSH à votre serveur en mode rescue.

Monter le volume sytème de notre serveur

mkdir /mnt/server

mount /dev/md127 /mnt/server

Accéder au volum système

cd /mnt/server

chroot /mnt/server

Vérifier la configuration réseau

vi /etc/network/interfaces

Vérifier les configurations firewall

cd /etc/iptables/

ls

vi /etc/pve/firewall/cluster.fw

vi /etc/default/pve-proxy ### systeme de base #### ls etc/systemd/system/ # vi /etc/systemd/system/firewalld.service # ln -s /dev/null /etc/systemd/system/firewalld.service

# or systemctl unmask pve-firewall.service # pve-manager.service -> /lib/systemd/system/pve-guests.service # ls /lib/systemd/system/pve* # root@rescue:/lib/systemd/system# vi pve-firewall.service

Retrouver /etc/pve en mode rescue

## En mode normal, le répertoire /etc/pve est en fait un volume monté en mode :

mount | grep pve

/dev/fuse on /etc/pve type fuse (rw,nosuid,nodev,relatime,user_id=0,group_id=0,default_permissions,allow_other)

## Toute la configuration de votre serveur Proxmox est sauvegardée dans ce fichier :

ls -l /var/lib/pve-cluster/config.db

# /etc/pve is a fuse mound of a sqlite db locaded under /var/lib/pve-cluster/config.db

sqlite3 /var/lib/pve-cluster/config.db ‘SELECT * FROM tree;’ | more

Dans le cas d’une sauvegarde, ou d’iun transfert sur un autre serveur, il semblerait qu’il faille reprendre ces 3 fichiers :

/var/lib/pve-cluster/config.db

/var/lib/pve-cluster/config.db-shm

/var/lib/pve-cluster/config.db-wal

lsblk

root@rescue:~# lsblk

NAME MAJ:MIN RM SIZE RO TYPE MOUNTPOINT

sdd 8:48 0 1.8T 0 disk

├─sdd2 8:50 0 40G 0 part

│ └─md127 9:127 0 40G 0 raid1

├─sdd3 8:51 0 8G 0 part

├─sdd1 8:49 0 511M 0 part

└─sdd4 8:52 0 1.8T 0 part

sdb 8:16 0 1.8T 0 disk

├─sdb4 8:20 0 1.8T 0 part

├─sdb2 8:18 0 40G 0 part

│ └─md127 9:127 0 40G 0 raid1

├─sdb3 8:19 0 8G 0 part

└─sdb1 8:17 0 511M 0 part

sdc 8:32 0 1.8T 0 disk

├─sdc2 8:34 0 40G 0 part

│ └─md127 9:127 0 40G 0 raid1

├─sdc3 8:35 0 8G 0 part

├─sdc1 8:33 0 511M 0 part

└─sdc4 8:36 0 1.8T 0 part

sda 8:0 0 1.8T 0 disk

├─sda4 8:4 0 1.8T 0 part

├─sda2 8:2 0 40G 0 part

│ └─md127 9:127 0 40G 0 raid1

├─sda5 8:5 0 2M 0 part

├─sda3 8:3 0 8G 0 part

└─sda1 8:1 0 511M 0 part

fdisk -l

root@rescue:~# fdisk -l

Disk /dev/ram0: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram1: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram2: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram3: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram4: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram5: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram6: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram7: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram8: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram9: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram10: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram11: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram12: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram13: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram14: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/ram15: 50 MiB, 52428800 bytes, 102400 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 4096 bytes

I/O size (minimum/optimal): 4096 bytes / 4096 bytes

Disk /dev/sdc: 1.8 TiB, 2000398934016 bytes, 3907029168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: C6EA383B-0112-4E78-AF63-5E1FB94B815F

Device Start End Sectors Size Type

/dev/sdc1 34 1046527 1046494 511M EFI System

/dev/sdc2 1046528 84932607 83886080 40G Linux RAID

/dev/sdc3 84932608 101709823 16777216 8G Linux filesystem

/dev/sdc4 101709824 3907025071 3805315248 1.8T Linux RAID

Disk /dev/sdd: 1.8 TiB, 2000398934016 bytes, 3907029168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: FD99AD38-105C-452E-9E18-E74643F1FAA5

Device Start End Sectors Size Type

/dev/sdd1 34 1046527 1046494 511M EFI System

/dev/sdd2 1046528 84932607 83886080 40G Linux RAID

/dev/sdd3 84932608 101709823 16777216 8G Linux filesystem

/dev/sdd4 101709824 3907025071 3805315248 1.8T Linux RAID

Disk /dev/sda: 1.8 TiB, 2000398934016 bytes, 3907029168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: 7AEDB46F-6D55-4F12-9EFA-820E06AF6F0B

Device Start End Sectors Size Type

/dev/sda1 34 1046527 1046494 511M EFI System

/dev/sda2 1046528 84932607 83886080 40G Linux RAID

/dev/sda3 84932608 101709823 16777216 8G Linux filesystem

/dev/sda4 101709824 3907025071 3805315248 1.8T Linux RAID

/dev/sda5 3907025072 3907029134 4063 2M Linux filesystem

Disk /dev/sdb: 1.8 TiB, 2000398934016 bytes, 3907029168 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

Disklabel type: gpt

Disk identifier: 231C39B5-40C6-49DB-A41F-B018DBD4BA93

Device Start End Sectors Size Type

/dev/sdb1 34 1046527 1046494 511M EFI System

/dev/sdb2 1046528 84932607 83886080 40G Linux RAID

/dev/sdb3 84932608 101709823 16777216 8G Linux filesystem

/dev/sdb4 101709824 3907025071 3805315248 1.8T Linux RAID

Disk /dev/md127: 40 GiB, 42916118528 bytes, 83820544 sectors

Units: sectors of 1 * 512 = 512 bytes

Sector size (logical/physical): 512 bytes / 512 bytes

I/O size (minimum/optimal): 512 bytes / 512 bytes

ls /dev/md*

root@rescue:~# ls /dev/md*

/dev/md127

/dev/md:

md2_0

zpool list

root@rescue:~# zpool list

no pools available

zfs list

root@rescue:~# zfs list

no datasets available

Accéder à la partition zfspool

Connectez-vous en SSH à votre serveur en mode rescue.

Monter le pool zfs de notre serveur : zpool import

## Il ne faut pas re-créer le pool ZFS au risque d'écraser / effacer les données de ce pool:

## zpool create -f -o ashift=12 zfspool raidz /dev/sda4 /dev/sdb4 /dev/sdc4 /dev/sdd4

root@rescue:~# zpool import

pool: zfspool

id: 13319131672309168082

state: ONLINE

status: The pool was last accessed by another system.

action: The pool can be imported using its name or numeric identifier and

the ‘-f’ flag.

see: http://zfsonlinux.org/msg/ZFS-8000-EY

config:

zfspool ONLINE

raidz1-0 ONLINE

sda4 ONLINE

sdb4 ONLINE

sdc4 ONLINE

sdd4 ONLINE

root@rescue:~# zpool import zfspool

cannot import ‘zfspool’: pool may be in use from other system, it was last accessed by bill (hostid: 0x398af4bc) on Thu Apr 8 14:07:21 2021

use ‘-f’ to import anyway

root@rescue:~# zpool import -f zfspool

zpool list

root@rescue:~# zpool list

no pools available

root@rescue:~# zpool list

NAME SIZE ALLOC FREE EXPANDSZ FRAG CAP DEDUP HEALTH ALTROOT

zfspool 7.08T 640K 7.08T - 0% 0% 1.00x ONLINE -

zfs list

root@rescue:~# zfs list

NAME USED AVAIL REFER MOUNTPOINT

zfspool 1.78G 5.02T 140K /zfspool

zfspool/vz 1.78G 5.02T 1.78G /var/lib/vz

Logical Volume Manager (LVM)

Le RAID logiciel

Anticipez les défaillances matérielles avec une solution RAID logicielle

OVH – Le RAID logiciel

OVH – Remplacer à chaud un disque sur un serveur en RAID logiciel

https://www.techno-science.net/glossaire-definition/RAID-informatique-page-4.html

Raid Z – Système de fichiers ZFS

https://www.recuperation-donnees-raid.com/raid-z

How to replace a failed disk in a ZFS mirror

https://jordanelver.co.uk/blog/2018/11/26/how-to-replace-a-failed-disk-in-a-zfs-mirror/

RAID 5 vs RAID 10 : lequel est le mieux pour vous ?

https://fr.diskinternals.com/raid-recovery/raid-5-vs-raid-10/

En savoir plus sur le ZFS

Site officel OpenZFS

https://openzfs.github.io/openzfs-docs/index.html

ZFS, vous connaissez ? Vous devriez ! (Christian quest – oct 2019)

https://cq94.medium.com/zfs-vous-connaissez-vous-devriez-1d2611e7dad6

ZFS en détail :

https://www.lambot.info/zfs-en-details/

https://fr.wikipedia.org/wiki/ZFS

https://en.wikipedia.org/wiki/ZFS

https://pve.proxmox.com/pve-docs/pve-admin-guide.html#chapter_zfs

https://pve.proxmox.com/wiki/ZFS_on_Linux

MySQL/ZFS Performance

https://www.percona.com/blog/mysql-zfs-performance-update/

ZFS snapshot - replication

Basics of ZFS Snapshot Management

https://klarasystems.com/articles/basics-of-zfs-snapshot-management/

Introduction to ZFS Replication

https://klarasystems.com/articles/introduction-to-zfs-replication/

Système de fichiers ZFS pour serveurs: installation et configuration

https://itigic.com/fr/zfs-file-system-for-servers-installation-configuration/

Me contacter

+33 (0)9 501 502 05

18 rue des Bouchers, 14400 BAYEUX

Lundi-Vendredi: 9h - 18h